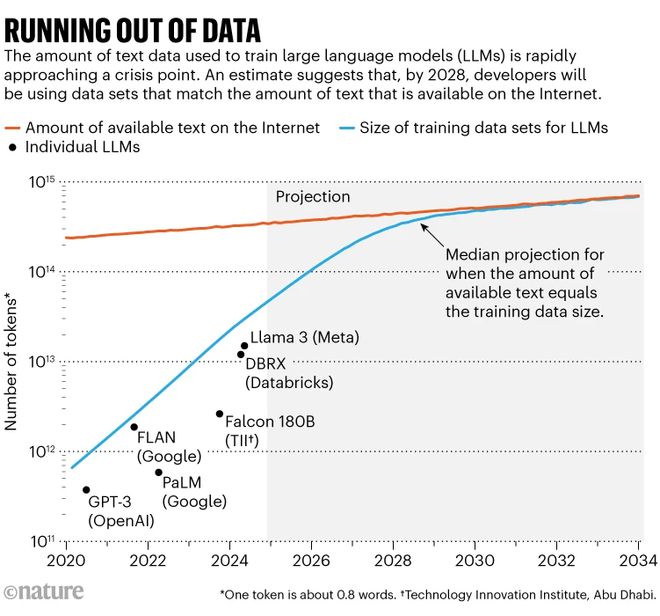

互联网是人类知识的汪洋大海,但并非无穷无尽。人工智能(AI)研究职员险些把它吸干了。 已往十年来,人工智能的爆炸性进步在很大水平上是通过扩大神经网络和在越来越多数据上举行练习而实现的。究竟证实,这种扩展(scaling)在使大语言模子(LLMs)更有本领复刻会话语言和发展推理等涌现特性方面的结果令人惊奇。但一些专家表现,昨们如今已经靠近了扩展的极限。部门缘故原由是盘算所需的能源不停膨胀,但也由于 LLM 开辟者正在耗尽用于练习模子的传统数据集。 本年,一项闻名的研究给出了一些数字,将这一题目推上了头条消息:Epoch AI研究职员猜测,到 2028 年左右,用于练习人工智能模子的典范数据集的规模将到达公共在线文本的估计总存量。换句话说,人工智能很大概在 4 年左右的时间内耗尽练习数据。与此同时,数据全部者(如报纸出书商)也开始限定其内容的利用方式,从而进一步收紧了数据的利用权。麻省理工学院人工智能研究员 Shayne Longpre 表现,这正在导致“数据公共资源”规模的危急,他向导着数据出处倡议(Data Provenance Initiative),这是一个对人工智能数据集举行审计的下层构造。 练习数据即将面对的瓶颈大概已经开始显现。Longpre 说:“我猛烈猜疑这种环境已经发生。”  只管专家们表现,这些限定有大概会减缓人工智能体系的快速发展,但开辟者们正在探求变通办法。Epoch AI 研究员 Pablo Villalobos 说:“我不以为大型人工智能公司有人感到恐慌。大概说,至少他们不会给我发电子邮件表现恐慌。” 比方,OpenAI 和 Anthropic 等著名流工智能公司已经公开认可了这一题目,同时表现他们有筹划办理这一题目,包罗天生新数据和探求非通例数据源。OpenAI 的一位发言人告诉《天然》:“昨们利用多种泉源的数据,包罗公开数据、来自互助同伴的非公开数据、合成数据天生和来自人工智能练习者的数据。” 即便云云,数据紧缩大概会迫使人们创建的人工智能天生模子范例发生变革,从大型、通用的 LLM 转向更小、更专业的模子。 数万亿练习 token 在已往十年中,LLM 的发展已经表现出其对数据的贪心需求。只管有些开辟者并不公布其最新模子的规模,但据 Villalobos 估计,自 2020 年以来,用于练习 LLM 的“token”(即单词的一部门)数目已经增长了 100 倍,从数千亿增长到了数万亿。 Villalobos 估计,现在互联网上的文本数据总量为 3100 万亿 token,这大概是互联网上的一大部门内容,只管总量巨大,难以确定。各种服务使用网络爬虫抓取这些内容,然后消除重复内容,过滤掉不受接待的内容,从而天生更干净的数据集:一个名为 RedPajama 的常用数据集包罗数十万亿个单词。一些公司大概学者本身抓取和清算,从而制作定制的数据集来练习 LLM。互联网上有一小部门内容被以为是高质量的,好比颠末人工编辑的、社会可担当的文本,这些文本大概出如今册本或消息报道中。 可用互联网内容的增长速率之慢令人惊奇:据 Villalobos 估计,其年增长率不到 10%,而人工智能练习数据集的规模每年增长一倍多。对这些趋势的猜测表现,这两条线将在 2028 年左右相交。 与此同时,内容提供商正越来越多地参加软件代码或美满其利用条款,以制止网络爬虫或人工智能公司获取其数据用于练习。Longpre 和他的同事于本年 7 月发布的一份预印本表现,很多数据提供商制止特定爬虫访问其网站的环境急剧增长。在三个重要净化数据会合质量最高、最常用的网络内容中,限定爬虫访问的 token 数目,从 2023 年的不到 3% 已上升到 2024 年的 20%-33%。 现在有几告状讼正在举行中,试图为人工智能练习中利用的数据提供商赢得补偿。2023 年 12 月,《纽约时报》告状 OpenAI 和微软侵占他们的版权;本年 4 月,Alden Global Capital 旗下的 8 家报社团结提起雷同诉讼。反方的论点是,应该答应人工智能像人一样阅读和学习在线内容,这构成了对质料的公道利用。OpenAI 曾公开表现,它以为《纽约时报》的诉讼“毫无根据”。 假如法院支持内容提供者应得到经济赔偿的观点,那么人工智能开辟者和研究职员将更难得到他们所必要的东西,包罗那些没有雄厚资金的学者。“这些生意业务对学术界的打击最大,”Longpre 说。他增补说:“拥有一个开放的网络有许多利益。” 探求更多数据 数据紧缩给人工智能的传统扩展计谋带来了一个潜伏的大题目。Longpre 说,固然可以在不增长练习数据的环境下进步模子的盘算本领或参数数目,但这每每会导致人工智能发展迟钝且本钱高昂——这通常不是主要选择。 假如目的是找到更多数据,一种选择大概是获取非公开数据,如 WhatsApp 消息或 YouTube 视频的转录。只管以这种方式获取第三方内容的正当性尚未得到验证,但公司确实可以获取本身的数据,一些交际媒体公司表现,他们利用本身的质料来练习人工智能模子。比方,Meta 公司表现,其 VR 头盔 Meta Quest 网络的音频和图像会被用于练习人工智能。然而,政策各有差别。视频集会平台 Zoom 的服务条款规定,该公司不会利用客户内容来练习人工智能体系,而转录服务公司 OtterAI 则表现,它确实会将去身份化和加密的音频和转录内容用于练习。 不外,据 Villalobos 估计,现在这些专有内容大概统共只有 4 万亿文本 token。思量到此中许多都是低质量或重复的内容,他说,纵然假设一个人工智能可以访问全部这些内容,而不会造成侵权或隐私题目,这也足以将数据瓶颈的时间推迟一年半。他说:“纵然数据存量增长十倍,也只能为你赢得三年左右的扩展时间。” 另一种选择大概是专注于天文或基因组数据等专业数据集,这些数据集正在快速增长。“AI 教母”李飞飞已经公开支持这一战略。她在本年 5 月举行的彭博社技能峰会上表现,思量到医疗、情况和教诲等范畴尚未开辟的信息,对数据枯竭的担心过于局促。 但 Villalobos 说,现在还不清晰这些数据集对练习 LLM 有多大的可用性和实用性。Villalobos 说:“很多范例的数据之间好像存在某种水平的迁徙学习。不外,我对这种方法并不抱太大盼望。” 假如天生式人工智能可以在其他数据范例(而不但仅是文本)上举行练习,其大概性将更为广阔。一些模子已经可以或许在肯定水平上对无标签的视频或图像举行练习。扩展和改进这些本领可以为更丰富的数据打开大门。 本年 2 月,在加拿大温哥华举行的一次人工智能集会上,Meta 首席科学家、纽约大学盘算机科学家、被誉为当代人工智能奠定人之一的 Yann LeCun 演讲中夸大了这些大概性。用于练习当代 LLM 的 10^13 token 听起来许多:根据 LeCun 的盘算,一个人必要 17 万年才气读完这么多。但是,他说,一个 4 岁的孩子在苏醒时仅仅通过观察物体所吸取的数据量就比这多 50 倍。LeCun 在 AAAI 年会上展示了这些数据。 让人工智能体系以呆板人的情势从本身的感官履历中学习,终极大概会使用雷同的丰富数据。LeCun 说:“昨们永久不大概通过语言练习到达人类程度的人工智能,那是不大概的。” 假如找不到数据,可以天生更多数据。为练习人工智能,一些人工智能公司费钱雇人天生内容,另一些公司则利用人工智能天生的合成数据。这是一个潜伏的巨大泉源:本年早些时间,OpenAI 表现他们天天天生 1000 亿个单词,即每年天生凌驾 36 万亿个单词,与当前的人工智能练习数据集规模相称。而且这种产出还在快速增长。 专家们同等以为,一样平常来说,合成数据好像实用于有明白规则的范畴,如国际象棋、数学或盘算机编码。人工智能工具 AlphaGeometry 利用 1 亿个合成示例,在没有人类演示的环境下,乐成练习出办理多少题目的本领。合成数据已经被用于真实数据有限或存在题目的范畴。这包罗医疗数据,由于合成数据不涉及隐私题目;也包罗主动驾驶汽车的练习场,由于合成汽车碰撞不会对任何人造成伤害。 合成数据的题目在于,递归循环大概会固化错误、放大误解并广泛低落学习质量。2023 年的一项研究创造了“模子自噬停滞”(Model Autophagy Disorder)一词来形貌人工智能模子怎样以这种方式“走向疯狂”。比方,一个部门基于合成数据练习的人脸天生人工智能模子开始绘制嵌有希奇哈希标志的人脸。 大概可以「以少胜多」 另一种计谋是放弃“越大越好”的概念。只管开辟者仍在继承构建更大的模子,并通过扩展来改进他们的 LLM,但很多人正在寻求更高效、更小的模子,专注于单个使命。这些模子必要提炼、专业的数据和更好的练习技能。 总的来说,人工智能已经在用更少的资源做更多的事变。2024 年的一项研究以为,由于算法的改进,每 8 个月左右,一个 LLM 实现雷同性能所需的盘算本领就会淘汰一半。 随着人工智能专用盘算机芯片的问世以及其他硬件的改进,人工智能为以差别方式利用盘算资源打开了大门:一种计谋是让人工智能模子多次重读练习数据集。斯坦福大学博士生、数据溯源筹划(Data Provenance Initiative)成员 Niklas Muennighoff 说,固然许多人以为盘算机具有完善的影象本领,只必要“阅读”一次资料,但人工智能体系是以一种统计方式工作的,这意味着重新阅读可以进步性能。在 2023 年发表的一篇论文中,他和他的同事在 HuggingFace 工作时发现,一个模子在重新阅读给定命据集 4 次后所学到的知识,与阅读雷同数目的唯一数据所学到的知识一样多——只管重新阅读的利益在此之后很快就消散了。 只管 OpenAI 没有透露其 o1 模子的规模或练习数据集的信息,但该公司夸大,该模子接纳了一种新方法:花更多时间举行强化学习(模子得到最佳答案反馈的过程),花更多时间思索每个相应。观察家们以为,这种模子将重点从海量数据集的预练习转移到了练习和推理上。Longpre 说,这为扩展方法增加了一个新的维度,只管这是一种盘算本钱高昂的计谋。 LLM 在阅读完互联网上的大部门内容后,有大概不再必要更多数据,就能变得更智慧。卡内基梅隆大学研究人工智能安全的研究生 Andy Zou 说,人工智能大概很快就会通过自我反思取得进步。Zou 说:“如今,它已经有了一个底子知识库,这大概比任何一个人都要强盛,”这意味着它只必要坐下来思索。“我以为昨们大概已经非常靠近这一点了。” Villalobos 以为,从合成数据到专业数据集,再到重新阅读和自我反思,全部这些因素都将有所资助。“模子既能自我思索,又能以各种方式与实际天下互动——两者的联合大概会推动前沿技能的发展。” https://www.nature.com/articles/d41586-024-03990-2 翻译:李雯靖 如需转载或投稿,请直接在公众号内留言  海量资讯、精准解读,尽在新浪财经APP

|